Staatlicher Zugriff auf Verschlüsselung: Ein zweischneidiges Schwert

Der britische Online Safety Act, der im Oktober 2023 in Kraft trat, verpflichtet Online-Plattformen und Suchdienste dazu, aktiv gegen illegale und schädliche Inhalte vorzugehen. Mit dem Gesetz will die britische Regierung Dienste wie WhatsApp und Apple iMessage verpflichten, verschlüsselte Kommunikation für Ermittlungsbehörden zugänglich zu machen. Die Regulierungsbehörde Ofcom überwacht die Einhaltung der Vorschriften und veröffentlicht schrittweise Leitlinien, die ab Sommer 2025 vollständig wirksam werden sollen. Dieser Umstand stößt weitläufig auf Widerstand, da er nicht nur im Widerspruch zu deutschen, sondern auch zu EU-weiten Datenschutzstandards steht. Eine Ende-zu-Ende-Verschlüsselung gilt dabei als zentrale Schutzmaßnahme, um personenbezogene Daten vor unbefugtem Zugriff zu sichern.

https://www.nortonrosefulbright.com/en-de/knowledge/publications/0b658a5a/online-safety-act

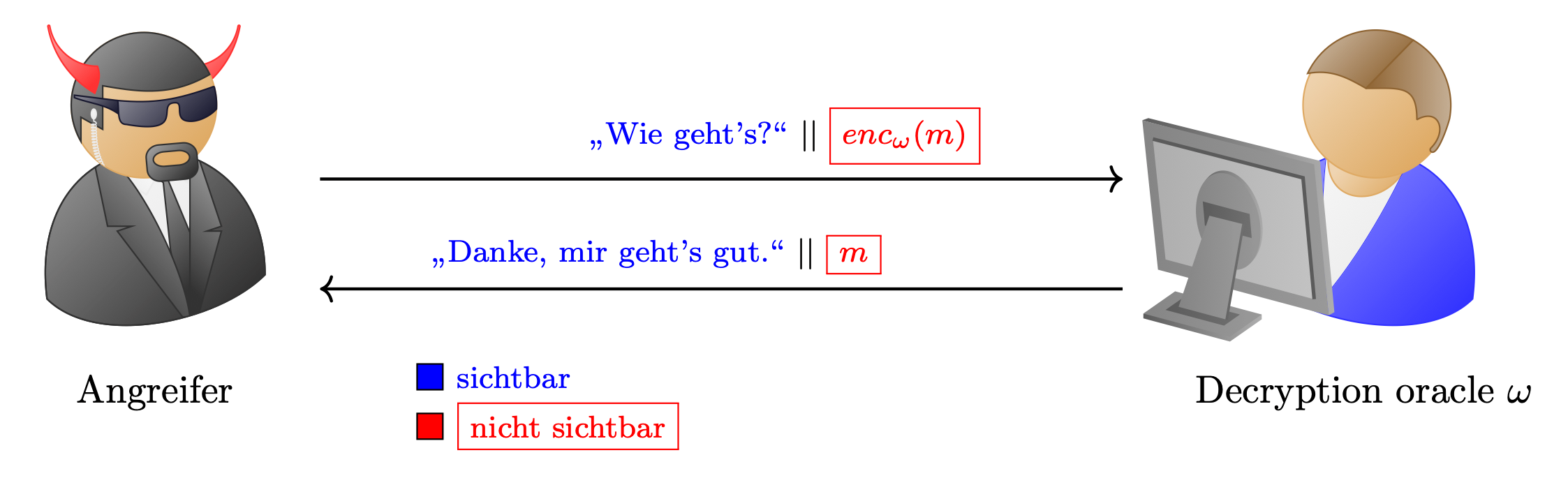

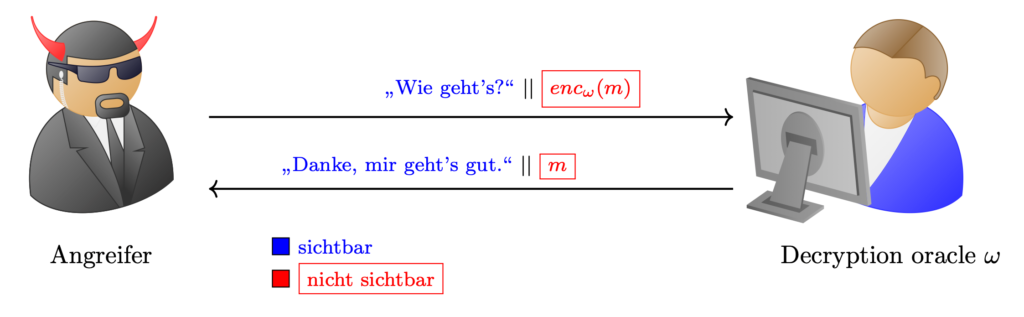

Kleiner Einschub: Ende-zu-Ende-Verschlüsselung bedeutet, dass eine Nachricht direkt in der Anwendung verschlüsselt wird, die der Absendende nutzt – und nur die Anwendung, mit der der Empfangende die Nachricht liest, kann sie wieder entschlüsseln. Die Verschlüsselung erfolgt also nicht nur auf dem Gerät, sondern durch die konkrete App, mit der kommuniziert wird. Dadurch bleibt die Nachricht auf dem gesamten Übertragungsweg geschützt – sie kann weder unterwegs entschlüsselt noch manipuliert werden.

Bei der Transportverschlüsselung hingegen übernimmt ein Kommunikationsprotokoll wie TLS während der Übertragung die Verschlüsselung. Die Nachricht kann dabei auf Sender- und Empfängerseite oder auf Zwischenstationen im Klartext vorliegen und somit eingesehen oder verändert werden. Das ist besonders relevant, da Sendender und Empfangender beim Nachrichtenaustausch meist nicht direkt miteinander kommunizieren, sondern über Server oder andere Vermittlungsstellen.

Sowohl Apple als auch WhatsApp wehren sich juristisch gegen die britischen Pläne. Wie Meta berechtigt einbringt, kann das Vorhaben zu einem „gefährlichen Präzedenzfall“ werden, der andere Staaten ebenfalls ermutigen könnte, Verschlüsselung zu untergraben.

https://heise.de/news/Grossbritanien-WhatsApp-springt-Apple-im-Kryptokrieg-zur-Seite-10443507.html

Da die Anordnungen des britischen Innenministeriums (UK Home Office) geheim erfolgen, muss Apple juristisch Druck ausüben, um überhaupt Teile der sogenannten „Schnüffelbefehle“ offenlegen zu können. Es ist unklar, wie viele Unternehmen bereits betroffen sind.

Ein Zwang zur Implementierung von Hintertüren in iOS würde nicht nur britische Nutzende betreffen. Da Apple weltweit einheitliche Software ausliefert, wären alle Nutzenden weltweit potenziell betroffen. Die britische Regierung könnte damit global die Sicherheit von Milliarden Geräten schwächen.

Ein „Generalschlüssel“ oder eine technische Hintertür ist ein Single Point of Failure. Selbst wenn dieser Schlüssel nur für legitime Ermittlungen gedacht ist, könnte er durch folgende Szenarien kompromittiert werden:

- Hackerangriffe auf staatliche IT-Infrastrukturen (z. B. SolarWinds, Microsoft Exchange)

- Insider-Leaks (vgl. Edward Snowden, Reality Winner)

- Fehlkonfigurationen oder unzureichende Schlüsselverwaltung (z. B. unverschlüsselte Key-Stores, schwache HSM-Policies)

https://thehackernews.com/2021/11/fbis-email-system-hacked-to-send-out.html

Ein kompromittierter Generalschlüssel würde den flächendeckenden Zugriff auf private Kommunikation ermöglichen – durch jeden, der ihn besitzt.

Einmal implementierte Hintertüren lassen sich nicht selektiv nutzen. Sie können von autoritären Regimen, kriminellen Gruppen, fremden Nachrichtendiensten genauso ausgenutzt werden wie von demokratischen Behörden. Kryptografie kennt keine politischen Intentionen – nur mathematische Schwächen.

Fazit: Sicherheit durch Verschlüsselung – nicht trotz.

Die Forderung nach dem Zugriff auf verschlüsselte Kommunikation ist verständlich, aber technisch gefährlich. Staatliche Systeme sind nicht immun gegen Angriffe. Wer ihnen Generalschlüssel anvertraut, riskiert, dass diese Schlüssel früher oder später kompromittiert werden.

Starke Verschlüsselung schützt nicht nur die Privatsphäre – sie ist ein Grundpfeiler der digitalen Sicherheit und letztendlich der Demokratie.