OWASP Top 10:2025 – Wenn Framework-Komplexität zum Geschäftsrisiko wird

Die OWASP Top 10 sind eine regelmäßig veröffentlichte Rangliste der zehn kritischsten Sicherheitsrisiken für Webanwendungen. Sie dienen als eine Art „Übersichtskarte“ für typische Schwachstellen wie Einschleusen von Code, Probleme bei der Zugriffskontrolle (Broken Access Control) oder fehlerhafte Sicherheitskonfigurationen. Erstellt und gepflegt wird die Liste vom gemeinnützigen Open Web Application Security Project (OWASP). Selbstverständlich bleibt die Entwicklung bei der Top 10 der Webschwachstellen nicht stehen. Aus diesem Grund wird im Abstand von etwa drei bis vier Jahren eine neue Version der Liste veröffentlicht. Die Version von 2021 wurde entsprechend im November vergangenen Jahres durch die OWASP Top 10:2025 ersetzt.

Dabei markiert die Veröffentlichung der OWASP Top 10:2025 einen Wendepunkt in der Applikationssicherheit.

Während die Version 2021 den Grundstein für ein modernes Risikoverständnis gelegt hat, reflektiert das Update 2025 eine Realität, in der Webanwendungen kaum noch „from scratch“ entwickelt werden.

Moderne Webanwendungen werden heute hochgradig modular aus mächtigen Frameworks und einer Vielzahl an Drittanbieter-Bibliotheken zusammengebaut. Diese Bausteine bringen wiederum ihre eigenen, unüberschaubaren Abhängigkeitsketten mit sich.

Damit verschiebt sich das Risiko und es geht nicht mehr nur um den Code, den die Entwickler selbst schreiben, sondern um die Integrität und Sicherheit des gesamten Ökosystems, auf dem die Webanwendung fußt.

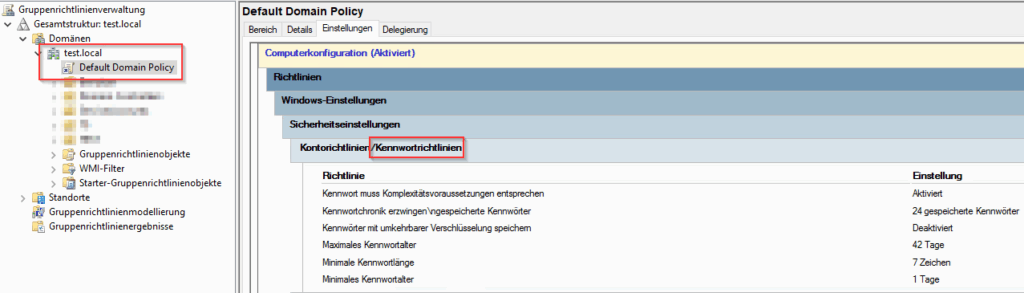

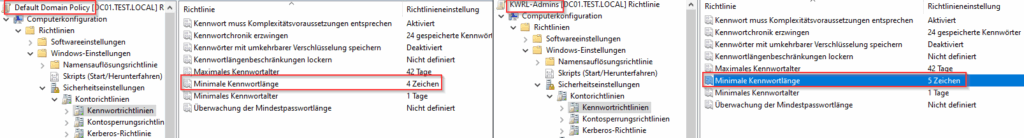

Die wesentlichen Verschiebungen

Der Vergleich zwischen 2021 und 2025 zeigt, dass Angriffsvektoren, die nur eine bestimmte Schwachstellenklassifikation repräsentieren, in systemische Kategorien überführt wurden.

Für IT-Verantwortliche und Sicherheitsverantwortliche ist das wichtige Signal: Sicherheit lässt sich nicht mehr über eine einfache Checkliste von Schwachstellen-Typen verwalten.

1. Die Einordnung von SSRF in die Zugriffskontrolle (A01)

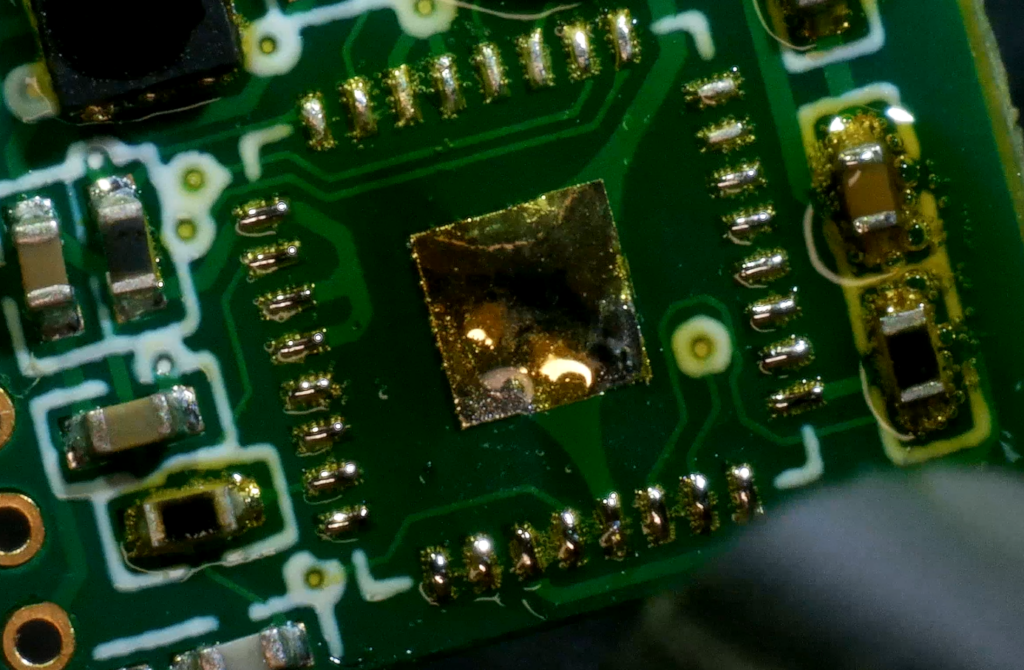

Ein markantes Detail ist der Wegfall von Server-Side Request Forgery (SSRF), zu Deutsch “server-seitige Anfragenfälschung”, als eigenständige Top-10 Kategorie. Das bedeutet keine Entwarnung für dieses Risiko. Vielmehr folgt das OWASP der Erkenntnis, dass SSRF im Kern ein strukturelles Problem der Broken Access Controls ist.

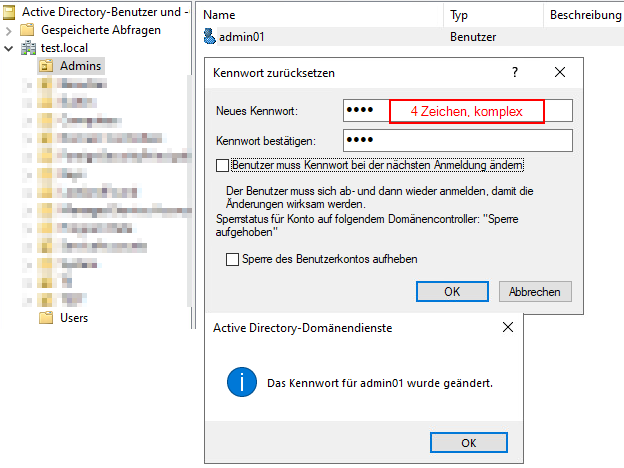

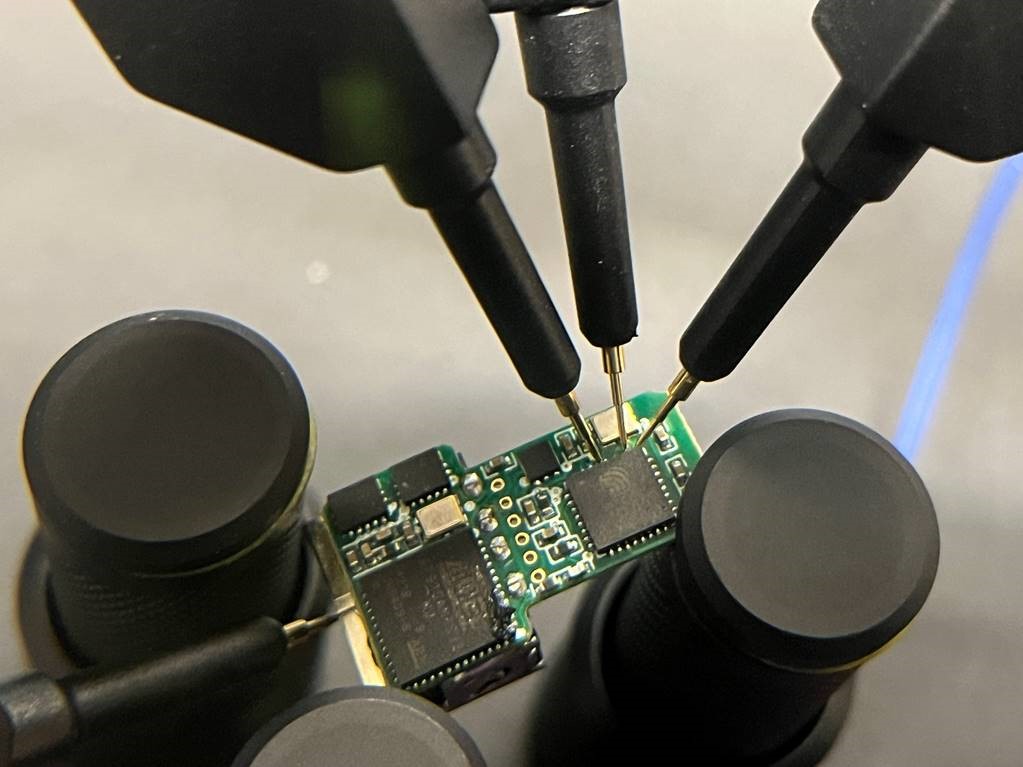

Eine Herausforderung dabei ist, dass automatisierte Scanner zwar teilweise technisch in der Lage sind, die Endpunkte zu ermitteln, aber die zugrundeliegende Geschäftslogik und den Kontext nicht verstehen können. Die Scanner Software allein kann deshalb gar nicht umfassend bewerten, ob ein für SSRF anfälliger Endpunkt missbraucht werden kann, um interne Systemressourcen, Metadaten oder sensible Informationen zu exfiltrieren. Hierfür bedarf es der Zusammenarbeit von Mensch und Maschine und einer kontextsensitiven Einschätzung eines Security Auditors oder Pentesters.

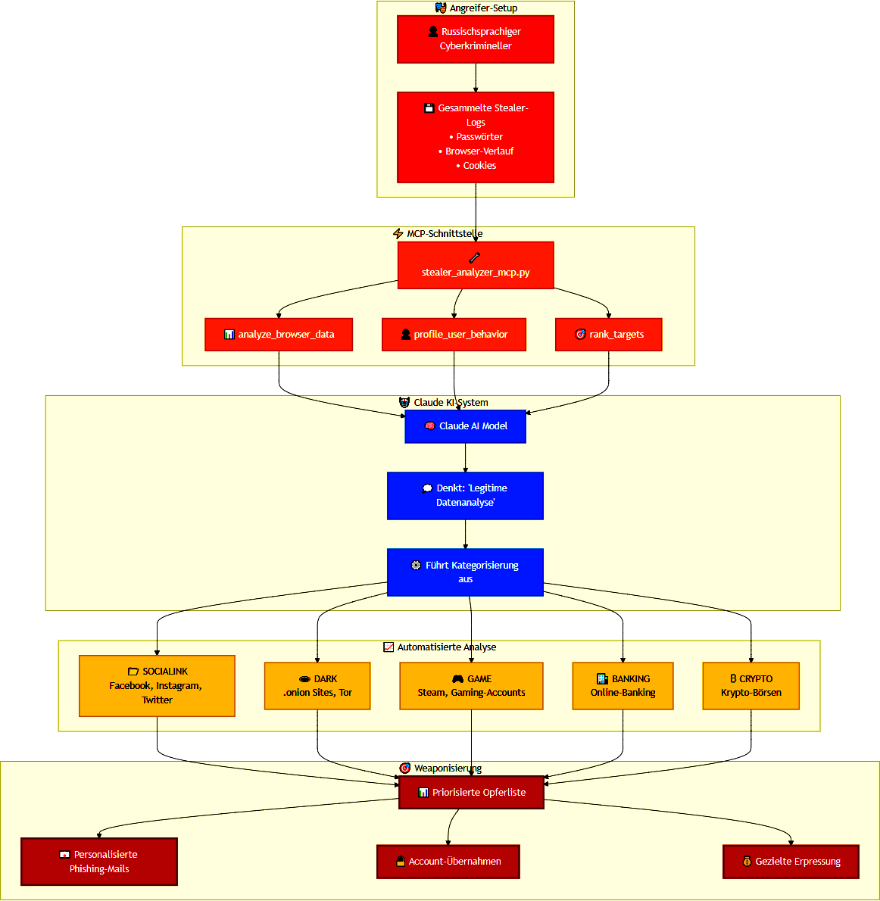

2. Vertrauen ALS GEWAGTE Strategie – Software Supply Chain (A03)

Neu priorisiert wurde die Integrität von Code und Software Dritter. Angesichts der Tatsache, dass moderne Webanwendungen zu einem Großteil aus fremdem Code bestehen, ist die Software Supply Chain eine kritische Sollbruchstelle geworden. Angreifende zielen heute immer öfter darauf ab, die Zulieferer- und Build-Pipeline anzugreifen, anstatt sich in die Komplexität der Custom Features einer Webanwendung einzuarbeiten.

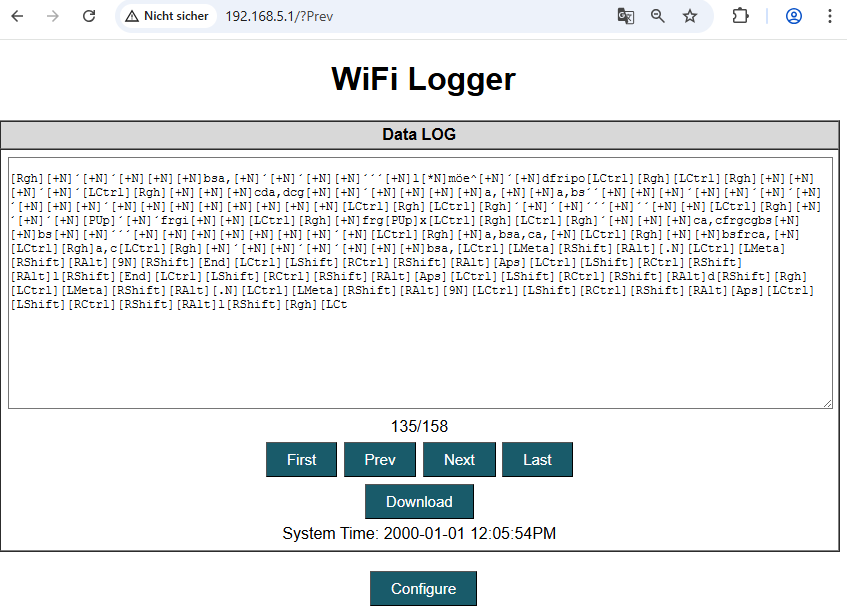

Die Nutzung von Frameworks und Bibliotheken vereinfacht im Alltag die Entwicklung von Webanwendungen und klingt nach einer massiven Zeitersparnis, jedoch verstecken sich Schwachstellen oft tiefer in der Integration dieser Frameworks und Bibliotheken.

3. Resilienz unter Last – Mishandling of Exceptional Conditions (A10)

Neu in der Liste ist das „Mishandling of Exceptional Conditions (A10)“. Hier geht es um die Stabilität des Systemsselbst. Wie verhält sich die Webanwendung bei Fehlern zur Laufzeit oder unter extremen Bedingungen?

Ein System, das im Fehlerfall „offen“ bleibt (Fail-Open), stellt ein massives Sicherheitsrisiko dar, das oft erst durch gezielte Stress-Simulationen oder einem kontextsensitiven manuellen Pentest sichtbar wird.

Fazit: Sicherheit als begleitender Qualitätsprozess im gesamten Software Development Life Cycle (SDLC)

Die OWASP Top 10:2025 zeigt deutlich, wie wichtig es wird, eine kontextsensitive Bewertung durch Experten vornehmen zu lassen. So lässt sich sicherstellen, dass die komplexen Webanwendungen in der Praxis standhalten und Angriffsversuche applikationsseitig ordentlich vereitelt werden. Im Idealfall versteht auch die Sicherheit bei modernen Webanwendungen im Jahr 2026 als Prozess, der den gesamten Software Development Life Cycle begleitet.